Mein Weg zur Computermusik

Karlheinz Essl im Gespräch mit Romain Versaevel27.-28. April 2016, Studio kHz

KHE: Das war während meiner Studienzeit in den achtziger Jahren. Ich habe 1979 begonnen, Musikwissenschaft zu studieren, aber erst 1981 die Aufnahmsprüfung für Komposition an der Wiener Musikhochschule gemacht. Während meines Musikwissenschaftsstudiums kam ich in Kontakt mit Gerhard Eckel, mittlerweile Professor für Computermusik an der Kunstuniversität Graz, mit dem ich bis heute befreundet bin. Er hat schon sehr früh mit Computern gearbeitet. Wir hatten an unserem Institut eine Abteilung für Schallforschung. Die hatten ein Forschungslabor an der Akademie der Wissenschaften, und damals schon mit Mainframe-Computer gearbeitetn. Gerhard war als Student von Anfang dort involviert und Software für Klanganalyse programmiert.

Meinen ersten Rechner habe ich mir 1985 gekauft habe, nachdem ich Computer zunächst total abgelehnt hatte. Denn in den ersten Jahren meines Musikstudiums hatte ich bei sehr konservativen Lehrern Theorieunterricht gehabt und ich mich nur für alte Musik interessiert: Kontrapunkt, Motetten und mittelalterliche Musik. Während meines Musikwissenschaftsstudium habe ich frühmittelalterliche Musik kennengelernt, die mich sehr fasziniert hat: Pérotin und die französische Notre-Dame-Schule um 1200. Und dann kam Gerhard und meinte, dass man mit dem Computer ziemlich interessante Sachen machen kann. Aber für mich kam das damals noch nicht in Frage.

Bald darauf begann ich mich aber für elektronische Musik zu interessieren, ausgelöst vor allem durch Stockhausen. Deswegen haben Gerhard und ich den Lehrgang für elektroakustische Musik an der Musikhochschule belegt. Im Studio war alles noch analog, ohne Computer, aber dafür mit Tonbandmaschinen. Bei dieser Gelegenheit haben wir mit Freunden eine Komponistengruppe gegründet mit dem schönen Namen "Kybernikos", um gemeinsam Konzerte mit Neuer Musik zu veranstalten. Einer von uns, er hieß Eugen Brochier, hat für eine Computerzeitschrift Testberichte geschrieben und deswegen immer die neuesten Computer zu Hause. Das muss man sich mal vorstellen: Das war 1984/1985, da sind die ersten PCs gerade erst herausgekommen! Im Sommer habe ich einen Monat lang Brochiers Wohnung gehütet, um seine Pflanzen zu gießen, und durfte dafür mit seinem Computer arbeiten. Das war ein Siemens Desktop-Computer, auf dem ich begonnen habe, meine Dissertation zu schreiben. Da habe ich gemerkt, wie praktisch das ist, wenn man den Computer als Schreibmaschine benutzt, da man damit Texte leichter verfassen und verändern kann. Und als er dann aus dem Urlaub zurückgekommen ist, habe ich ihm gesagt: "Ich bin jetzt von deinem Computer abhängig, ich brauche auch so was, was soll ich mir kaufen?" Und er hat gemeint, dass ich noch zwei Monate zuwarten soll, bis ein neues Gerät auf den Markt kommt, das er mir empfehlen würde: den Atari ST.

Den Apple Macintosh gab es zwar schon früher, aber der war für uns Studenten viel zu teuer. Der Atari hat nur ein Drittel gekostet - immer noch viel Geld! - und hatte auch eine graphische Benutzeroberfläche. Den habe ich mir dann gekauft. Das Problem war, das es kaum Software gab, bloß ein Textadventure-Game und BASIC. Und dann hat mein Freund Gerhard gesagt: "Jetzt hast du einen Computer, jetzt können wir da mal Experimente machen!" Ich habe mich damals für Algorithmen und serielle Musik interessiert, und mit BASIC haben wir unsere ersten kleinen Strukturgeneratoren geschrieben, was ich unglaublich interessant fand. Ich erzeugte damit nicht nur musikalische Strukturen, sondern auch generative Grafiken:

Algorithmische Computergrafik

© 1987 by Karlheinz Essl

Papert und Piaget wollten eine Programmiersprache entwicklen, die einfach und intuitiv ist, und die es Kindern ermöglicht, ihre eigenen Programme zu schreiben, und ihre Programmcodes in anderen Projekten weiter zu verwenden. Eines der Ausgabe-Instrumente war eine sogenannte turtle, ein graphisches Ausgabegerät, mit dem man Figuren zeichnen konnte. Dieses Ausgabegerät war sehr intuitiv, man konnte es angreifen und man konnte ihm beim Zeichnen zusehen. Das hat diese Software sehr populär gemacht.

Für meine Atari gab es bereits einen Logo-Interpreter; der war aber nicht gut. Kurze Zeit später haben zwei deutsche Mathematiker eine Logo-Implementation auf den Markt gebracht, die hieß xLogo - "experimential Logo". Diese Sprache hat mich sehr beeindruckt, weil ich damit meine eigenen MicroWorlds bauen konnte in Bereich musikalische Komposition. So habe habe ich begonnen, mit Logo bestimmte Formalismen bzw. Algorithmen zu kodieren (COMPOSE for xLOGO, 1988 f.) und habe damit mindestens zehn Jahre lang meine Instrumentalmusik komponiert.

Wenn man Koenigs Stück hört, klingt es aber überhaupt nicht zufällig. Dies hat mich damals sehr verblüfft... Daraufhin habe ich begonnen, strukturelle Konzepte von Koenig, wie er sie in seinem ersten Computerprogramm Projekt 1 verwirklicht hat (einem Klassiker der algorithmischen Komposition), in mein xLOGO Compose Environment zu integrieren. Es entstand eine Art Werkzeugkasten, mit dem ich eine Reihe von Instrumentalwerken komponierte.

Karlheinz Essl im Gespräch mit Gottfried Michael Koenig

Studio kHz, 2 Apr 2014

Und wie diese neue Ircam Signal Processing Workstation in einem Beta-Stadium fertig war, wurden verschiedene junge Komponisten aus der ganzen Welt eingeladen, damit ein Stück zu machen - um das System zu testen. Ich hatte das Glück, auch darunter zu sein. Dafür musste ich am IRCAM einen Sommerkurs belegt und habe dort viele neuen Dinge kennengelernt, die Softwares, die Studios... Dabei bin ich mit der Programmiersprache Max in Berührung gekommen, die damals auf der Ircam-Workstation gelaufen ist - in einer sehr rudimentären Version, die mehr an Pd als an das heutige Max erinnert.

Karlheinz Essl im Studio 5 des IRCAM in Paris

Foto © 1993 by Sophie Steinberger

Als 1993 wieder nach Wien zurückgekehrt bin, dachte ich mir: "Jetzt hatte ich so tolle Möglichkeiten am IRCAM, aber wie soll ich das nun zu Hause machen? Ich habe ja nicht das Geld, mir eine IRCAM Workstation zu kaufen." Jean-Baptiste Barrière hat mir aber zum Abschied gesagt: "Warte noch fünf Jahre, dann hast du das alles auch zu Hause auf deinem Laptop!" Das konnte ich mir gar nicht vorstellen. Aber tatsächlich, 1998 brachte Apple Laptops mit dem Motorola G3 Prozessor heraus, eine für damalige Verhältnisse sehr schnelle CPU, auf der man ohne Signalprozessor Klang in Echtzeit berechnen konnte. Miller Puckette hatte dafür für Max eine neue Audio-Erweiterung, genannt MSP (Max Signal Processing), entwickelt. Das Environment, das ich zuvor auf der IRCAM Workstation gehabt hatte, lief nun ohne zusätzliche Hardware direkt auf meinem G3 Powerbook! Unlängst habe ich es wieder in die Hand genommen und hochgefahren, weil ich nach einem bestimmten File suchte; nach 18 Jahren funktioniert es immer noch!

Das war also in kurzen Zügen der Abriss: von der Rockmusik zur seriellen Musik, von der seriellen Musik zur elektronischen Musik, von der elektronischen Musik zur Computermusik, von der Partitursynthese zur Live-Elektronik: ein etwa 30-jähriger Prozess.

Karlheinz Essl mit seinem Powerbook G3 (1998)

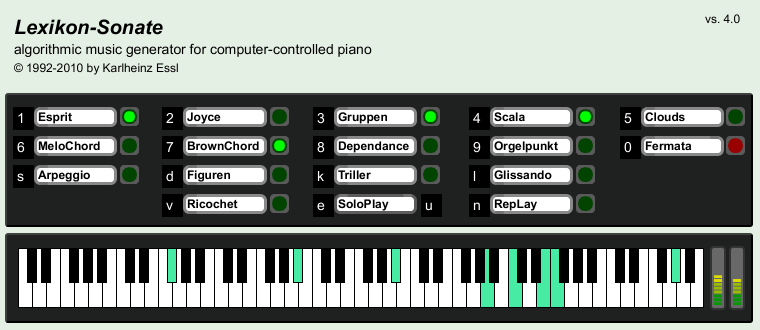

KHE: Nein, überhaupt nicht, ich habe immer gedacht: "Warum reden die dauern von Echtzeit? Ist mir doch egal, ob ich jetzt eine Nacht warte, bis der Rechner mir eine Seite, eine Partitur oder Tabelle ausdruckt, die ich dann ohnehin in Notation übertragen muss." Als ich dann aber mein erstes Programm in Max geschrieben habe - die Lexikon-Sonate - war das zunächste mehr ein Test um zu sehen, was und wie man damit komponieren kann. Mit Hilfe von Max und einem über MIDI angeschlossenen Piano-Sampler, wollte ich bestimmte musikalische Strukturen erzeugen, die man am Klavier spielen kann. Und dabei erkannte ich fasziniert, dass wenn alles in Echtzeit passiert ich dem Computer beim Komponieren zuhören kann. Uund dann kann ich unmittelbar eingreifen, und sofort verändert sich die Harmonik oder die Geschwindigkeit. Da erst habe ich verstanden, was "Echtzeit" wirklich bedeutet.

Benutzeroberfläche von Karlheinz Essls Lexikon-Sonate

KHE: Ja. Ich habe ein bisschen SuperCollider experimentiert, aber ich hatte noch zu wenig Zeit, mich eingehender damit zu beschäftigen. Was ich heute sehr aufregend finde ist Opusmodus. Das ist eine neue Generation von algorithmischer Kompositionssoftware, die ein Kollektiv von französischen und polnischen Musikern entwickelt. Sie ist erst seit einem Jahr auf dem Markt und läuft unter Lisp. Es beeinhaltet eine unglaublich mächtige Implementation von MusicXML, womit man direkt musikalischen Notationen generieren kann, die wirklich gut aussehen. Ein sehr durchdachte Sprache, mit deren Algorithmen musikalische Strukturen, Grafiken, Notationen, MIDI Files etc. erzeugt werden können. Das System ist offen und frei konfigurierbar. Es hat eine riesige Bibliothek von Funktionen, die man verwenden oder erweitern kann. Ich stehe in Kontakt mit dem Entwickler Janusz Podrazik, den ich zu einem Workshop an die Wiener Musikuniversität eingeladen habe. Damit möchte ich mich in der nächsten Zeit intensiver beschäftigen; so komme ich wieder zurück zur guten alten Partitursynthese. Das habe ich lange Zeit nicht mehr gemacht, weil mich Echtzeitprozesse und die Live-Elektronik in den letzten Jahren sehr beschäftigt haben.

Karlheinz Essl: Ich höre sehr viel Musik, vor allem professionell, weil ich viel mit Studenten zu tun habe und mich darüber informiere möchte, was momentan gerade komponiert und produziert wird. Das ist das professionelle Musikhören. Das mache ich ständig - da geht es natürlich in erste Linie um neue Musik, elektronische Musik, experimentelle Musik... Aber es gibt auch Musik, die ich zu meinem Vergnügen höre. Aber das sind Sachen, die ganz weit weg sind von dem, was ich selber mache. Es ist die Musik, die ich früher gehört habe, als ich mich intensiv mit bestimmten Arten von avancierter Rockmusik beschäftigt habe. Diese Musik höre ich immer noch gern, zum Beispiel Gentle Giant. Eine meiner Lieblingsgruppen ist eine Band aus Deutschland - CAN -, das waren Krautrock-Exponenten, die auch mit Karlheinz Stockhausen gearbeitet hatten; sie waren teilweise seine Schüler. Über diese Band bin ich eben auf diesen Komponisten aufmerksam geworden. Und das war dann auch die Brücke zur elektronischen Musik.

KHE: ...an einer berufsbildenden Schule mit Schwerpunkt Chemie mit einem Abschluss zum Chemieingenieur. Dort habe ich mein naturwissenschaftliches Rüstzeug gelernt.

RV: Und kurz danach haben Sie sich dann für Musikwissenschaft entschieden?

KHE: Gegen den Willem meiner Eltern, die meinten, ich sollte besser etwas Anständiges lernen. Ich habe seit frühester Jugend musiziert, in Bands gespielt, Hausmusik gemacht, in einem Kirchenchor gesungen und Kontrabass in einem Streichorchester gespielt. Deshalb war Musikwissenschaft für mich das Naheliegendste. Ich habe dann wieder Klavierunterricht genommen bei meiner alten Lehrerin, die meinte, ich sollte unbedingt Komposition studieren, weil sie Musikwissenschaft allein zu trocken fand. Sie hat mich zu Alfred Uhl geschickt, der mich auch tatsächlich bei sich zu Hause empfangen hat. Ein alter, sehr freundlicher Herr, der sich meine Kompositionen angesehen hat und mich ermutigt hat, die Aufnahmsprüfung an der Wiener Musikhochschule zu wagen. Die ich dann zum Glück auch geschafft habe.

RV: Ihre Eltern waren damit nicht einverstanden?

KHE: Das kam erst später. Damals haben sie begonnen, im kleinen Maßstab zeitgenössische Kunst zu sammeln, natürlich noch ohne Museum, sehr bescheiden. Aber mit Musik hatten sie damals noch nicht so viel am Hut...

KHE: Mein musikalische Sprache hat sich im Lauf der Zeit stark geändert. In den 90er Jahren, also nach meinem Studium, war ich sehr beeinflusst vom Serialismus im Sinne von Pierre Boulez als Fortführung der Wiener Schule. Da habe ich viel Kammer- und Ensemblemusik geschrieben, inspiriert von der Ästhetik der New Complexity, die ich in Darmstadt kennengelernt hatte.

1997 war ich composer-in-residence bei den Salzburger Festspielen und wurde dort im Rahmen der Reihe "Next Generation" präsentiert. Ich hatte dort Portraitkonzerte mit großartigen Ensembles wie dem Klangforum und dem Ensemble Modern mit tollen Dirigenten wie Hans Zender. Und ausserdem zwei Klanginstallationen: die interaktive Lexikon-Sonate auf einem Yamaha Disklavier und das Klangenvironment Amazing Maze im Mirabellgarten. Für einen 37-jährigen wohl der Höhepunkt einer Karriere! Und obwohl dort alles ist sehr gut gelaufen ist, bin ich nach dem Festival in ein tiefes Loch gestürzt. Ich habe mir gedacht: "War es das jetzt? Ist das ein Leben? Ich sitze am Schreibtisch und komponiere Stücke, die irgendwann gespielt und dann ein-, zweimal aufgeführt werden, und dann sitze ich hier wieder allein zu Hause und schreibe die nächste Partitur."

Früher, als ich noch mit meinen Bands gespielt habe, hatte ich mindestens einmal in Monat ein Konzert. Wir haben viel geprobt und improvisiert und sehr interessante Sachen erlebt. Aber jetzt sitze ganz allein in einem Elfenbeinturm und schreibe meine Partituren. Und dann habe ich zu mir gesagt: "Ich muss da herauskommen! Ich möchte wieder als Performer werden auf die Bühne gehen und live spielen." Aber dann habe gemerkt, dass ich kein Instrument mehr richtig beherrsche. Früher habe ich viel Klavier gespielt, aber später aufgegeben. Dann habe ich Kontrabass (Konzertfach) studiert und musste das auch aufgegeben, um mehr Zeit zum Komponieren zu haben. Früher hatte ich E-Gitarre gespielt, aber dieses Instrument auch schon vor langer Zeit an den Nagel gehängt. Das heißt, ich konnte zwar einige Instrumente spielen, hatte aber keine Praxis. Weil ich als Komponist ich ein bestimmtes Niveau erreicht hatte, konnte ich als Instrumentalist nicht wieder von vorne anfangen. Die Lösung war, ein eigenes Instrument zu erfinden. Und da habe ich begonnen, als MaxMSP herausgekommen ist, mein eigenes Instrument zu bauen, das ich m@ze°2 nannte.

Darauf werde ich heute abends spielen, das gibt es immer noch. Ich habe dieses Software-Instrument fast 20 Jahre ständig weiterentwickelt. Um damit Erfahrungen zu sammeln, habe ich 1998 ein mehrteiliges Projekt mit dem Titel fLOW initiert. Es basiert auf einem Soundscape-Generator, den ich in Max geschrieben habe, zu dem verschiedene Musiker improvisieren. MusikerInnen aus ganz unterschiedliche Bereichen wie Jazz, experimentelle Musik, neue Musik, Klassik. Und dabei habe ich gelernt, wie das ist, mit Musikern aus verschieden Sujets und musikalischen Idiomatiken zu arbeiten. Und dadurch hat sich auch mein Stil als Komponist geändert. Meine Musik geht heute viel mehr vom Hören aus, obwohl sie weiterhinauf konstruktiven Konzeptionen hat und Algorithmen basiert. Aber sie ist nicht mehr so hermetisch, am Schreibtisch austariert, sondern bringt die eigene Erfahrung als Instrumentalist mit ein. Sie hat sich stark verändert durch meine jahrelange Erfahrung mit Live-Elektronik und Echtzeit-Algorithmen.

RV: Für wenn komponieren Sie? Welchen Hörer stellen Sie sich vor, wenn Sie komponieren oder live improvisieren?

KHE: Ich stelle mir keinen bestimmten Hörer vor, aber ich stelle mir immer ein Publikum vor. Ich komponiere nicht abstrakt für den luftleeren Raum. Das war früher vielleicht ein bisschen anders. Heute versuche ich mir vorzustellen, wie sich die Musik im Raum entfaltet und auf die HörerInnen wirkt. Das heißt, ich denke beim Schreiben immer an die Menschen, aber auch an den Akt des Hörens: Wie gestalte ich Zeitverläufe, damit sie auch wahrgenommen werden können? Was überrascht, was kann langweilen? So gesehen arbeite ich zwar empirisch, aber immer auf einer fundierten strukturellen Basis.

KHE: Das ist ein ganz wichtiger Punkt! In dem Improvisationsprojekt OUT OF THE BLUE mit der Sängerin Agnes Heginger wird nie geprobt. Wir treten umgeprobt, aber gut vorbereitet vor unser Publikum und spielen "out of the blue". Es gibt zwar immer ein Konzept oder einen Rahmen – heute ist es Friedrich Nietzsche, ein anderes Mal ging es um die Liebe. Agnes liest viel und hat eine breite Literaturkenntnis. Sie bringt alles Mögliche an Texten aus Büchern und Notizen mit. Weder sie noch ich wissen im aber Vorhinein, was wir von diesem Material verwenden werden. Und dann beginnt ein Spiel coram publico, wo wir uns gegenseitig die Bälle zuwerfen und damit aus dem Augenblick heraus gemeinsam ein Stück komponieren. Wenn man die Aufnahmen später anhört, vermittelt sich oft der Eindruck, als wären das gut einstudierte Kompositionen. Und das geht mit Agnes Heginger deshalb so gut, weil sie eine unglaubliche technische Bandbreite hat, weil sie sehr offen und flexibel ist und spontan auf Klänge und Situationen reagieren kann. Umgekehrt kann ich zu dem, was sie macht, sofort eine Antwort auf meinem Laptop geben.

OUT OF THE BLUE: Karlheinz Essl (Live-Elektronik) & Agnes Heginger (Stimme)

Oh Nacht, oh Schweigen, oh todtenstiller Lärm!

Essl Museum Klosterneuburg (27 Apr 2016)

KHE: Das ist schwer zu sagen... Meine ersten ernstzunehmenden Kompositionen habe ich als Fortsetzung der Wiener Schule (Schönberg, Webern, Berg) gesehen. Das habe ich aber bald abgeworfen. Danach kam der Serialismus mit seinen abstrakten Konzepten. Heute interessieren mich Berühungspunkte zu anderen Kulturen der Welt, zum Beispiel China. (Zeigt ein Instrument). Das ist eine chinesische Guzheng, eine sog. Wölbbrettzither mit 21 pentatonisch gestimmten Saiten. In meinem Stück river_run habe ich dieses Instrument so umgestimmt, dass sich die pentatonische Zellen nicht in der Oktave, sondern in der großen Septime wiederholen:

Guzheng-Stimmung in Karlheinz Essls river_run (2016)

Dadurch entsteht ein panchromatisches Total auf Basis einer pentatonische Zelle, die chromatisch verschoben wird. Dies öffnet ganz neue harmonische Räume! Was dabei herauskommt, erinnert zwar immer wieder an die klassische chinesische Guzheng; durch die Live-Elektronik aber wird der Klang stark ins Orchestrale transformiert wird.

KHE: Schon während meiner Studienzeit in den achtziger Jahren habe ich mich mit allen möglichen Formen von Algorithmen beschäftigt, auch zur Generierung von musikalischen Strukturen. Daneben habe ich mich auch für experimentelle Literatur interessiert, die mit ähnlichen Methoden arbeitet. In Österreich gab es nach dem zweiten Weltkrieg eine Formation von Schriftsteller, die Wiener Gruppe. Da waren ganz berühmte österreichische Autoren versammelt, wie H.C. Artmann, Konrad Bayer, Gerhard Rühm. Die hatten einen sehr strukturellen Zugang zur Literatur und versucht, mit wissenschaftlichen Methoden Texte zu (de)konstruieren. In diesem Zusammenhang bin ich auf eine französische Literatengruppe namens OuLiPo aufmerksam geworden, die mit recht ähnlichen Ideen arbeiteten. Und über die bin ich dann auf Georges Perec gestoßen, mit dem ich mich eine Zeit lang intensiv beschäftigt habe. Obwohl ich kaum Französisch kann, habe ich sein Buch La Disparition zweisprachig gelesen, parallel die deutsche Übersetzung und das französische Original, und habe gemerkt, wie unglaublich gut das übersetzt wurde.

RV: Dafür müssen Sie doch ein bisschen Französisch können!

KHE: Ja, ein bisschen vielleicht, ich habe ja eine Zeit lang in Frankreich gelebt, als ich in Paris am IRCAM gearbeitet habe. Ich kann zwar nicht sprechen, aber lesen. Es gibt diese geniale Übersetzung Perecs von Eugen Helmlé, der als Deutsch-Franzose selbst zweisprachig war. Mich hat es sehr beeindruckt, dass es möglich ist, ein so kompliziertes Buch ganz ohne den Buchstabe E (den häufigsten Buchstaben in der deutschen und französischen Sprach) sogar ins Deutsche zu übersetzen, ohne diesen Buchstaben!

RV: Haben Sie auch andere Literatur für Ihre Musik benutzt?

KHE: Ich habe mich schon in meiner Schulzeit intensiv mit E. T. A. Hoffmann und der Wiener Gruppe beschäftigt. Und später auch mit Andreas Okopenko, dessen Lexikon-Roman mit seiner Hypertext-Struktur Ausgangspunkt meiner Lexikon-Sonate war. Diese ist bereits in Paris am IRCAM entstanden; ursprünglich als Studie, um die Programmsprache Max besser kennenzulernen. Und als ich dann nach Wien zurückgekehrt bin, wurde ich von den Libraries of the Mind angesprochen, einer Gruppe von Computerwissenschaftlern, Netzaktvisten und Künstlern; die wollten Okopenkos Lexikon-Roman als interaktives elektronisches Buch herausbringen. Dies geschag alles noch vor dem Siegeszug des World-Wide Webs mit seinen Hyperlinks! Dabei habe ich gemerkt, dass das, was ich in Paris zur selben Zeit gemacht habe, genau in die gleiche Richtung zielt, und damit hatte ich auch schon den Titel für mein generatives Klavierstück: Lexikon-Sonate!

In dieser Zeit hatte ich auch Kontakte zu zwei anderen österreichischen Autoren meiner Generation, Ferdinand Schmatz und Franz Josef Czernin, die ein eigenes Computerprogramm namens POE (Poetic Oriented Evaluations) entwickelt hatten. Sie haben in Grunde auch mit Strukturgeneratoren gearbeitet und bestimmte Algorithmen entwickelt wie Textfilter oder -generatoren, mit denen man Texte manipulieren und erzeugen kann.

Zuvor hatte ich auch mit Perl experimentiert auf Anregung von Florian Cramer, einem Literaturwissenschaftler und Netzaktivisten, der seit 20 Jahren eine höchst bemerkenswerte Website mit algorithmischer Literatur betreibt. U.a. findet sich dort eine Umsetzung von Raymond Queneaus (Cent mille milliards de poèmes. Cramer hat mir dabei geholfen, einige meiner Stücken ins Web zu bekommen, wie zum Beispiel die Internetversion der multimedia Installation MindShipMind.

KHE: Nie. Also wenn man sich auf diesem Echtzeitsansatz einlässt, gehen nur bestimmte Sachen. Also zum Beispiel Dinge wie Backtracking, das funktioniert in Echtzeit nicht. Man kann nicht sagen: ich generiere erstmal eine Struktur, die ich dann vergleiche und optimiere, das geht nicht. Das heißt, man muss einen ganz anderen Weg einschlagen.

RV: Meiner Meinung nach ist es auch mit der Programmiersprache Max verbunden. Ich habe den Eindruck, dass Max nicht dazu gebraucht wird, sich Algorithmen mit Schleifen und so weiter zu vorstellen.

KHE: Ja, ja. Also die Struktur der Schleife, wie das in Programmiersprachen mit C oder so ist, wird anders gelöst. Das ist ein völlig anderer Ansatz. Und das ist vielleicht ganz gut, aus diesem Schleifendenken herauskommt. "for", "if", "while, oder so was... Man muss das irgendwie anders lösen. Aber weil alles in Echtzeit läuft, und die Zeit vorbeigeht, ist die Zeit der drohende Faktor; das entspricht, wie man spielt oder wie man Musik macht. Beim Komponieren ist es anders. Beim Komponieren ist man im Grunde in einem anderen Modus: da kann man immer in der Zeit vor und zurück, und Beziehungen herstellen und verbessern. Aber wenn man sozusagen Live spielt oder improvisiert, dann muss man immer mit der Zeit arbeiten. Alles was passiert ist, ist nicht wiederholbar – oder man kann vielleicht versuchen, zurückzugehen, etwas Ähnliches zu machen, aber es gibt ein ständiges Weiterfließen der Zeit.

RV: Wenn Sie nicht mehr in Echtzeit, sondern "out of time" komponieren, wie benutzen Sie den Computer? Was machen Sie lieber: musikalische Ideen implementieren, oder mit dem Computer spielen, um solche Ideen zu finden?

RV: Ich habe irgendwo gelesen (und habe es komisch gefunden!), dass Sie es auch zu persönlich, fanden, von Tonhöhen und Harmonie zu sprechen. Was soll das bedeuten?

KHE: Ja, das ist richtig! Also, es ist wie ein geheimes Handwerk, mit dem ich einfach umgehe, und das nicht theoriefähig. Ich erinnere mich, ich hatte vor einiger Zeit ein Stück geschrieben für Toy-Piano und Ensemble, under wood, und da hat die Musikwissenschaftlerin Gesine Schröder einen Aufsatz geschrieben über das Stück und hat dann eine Analyse gemacht, nur über die harmonische Struktur. Sie hat einfach unglaublich interessante Sachen herausgefunden, so wie ich denke! Sie hat ein Intervallfeld aufgezeichnet und hat mir auch gefragt: haben sie das wirklich so gemacht, und ich habe gesagt: ja ja, das stimmt, das ist richtig! (Gelächter) Aber das ist gar nicht so wichtig, das ist Handwerk, das brauche ich um die Klangräume abzustecken, und damit es auch sinnvoll zusammenklingt. Aber das ist gar nicht so wichtig, sondern das geht eigentlich mehr um die Art von Strukturen und Klänge, die entstehen, die diese Harmonik quasi eingebettet sind. Es ist nämlich interessant in der Musiktheorie – das Fach Musiktheorie- ist sehr Tonhöhen-orientiert. Die Tonhöhen werden immer analysiert. In der Musik, die ich schreibe geht es viel um Klang und um anderes, und das wird eigentlich nicht berücksichtigt. Ich habe auch gesagt, es ist etwas ganz Nebensächliches, das ist nicht im Vordergrund. Das war ihr Ansatz gewesen.

KHE: Harmonisch nicht, weil die Harmonik sehr komplex ist. Die Harmonik ist in den einzelnen Generatoren unterschiedlich gestaltet. "Esprit" zum Beispiel arbeitet mit einer Art von Brown'schen Zufall, mit bestimmten Wiederholungsverboten, was Intervalle und Töne anbelangt. Aber es generiert sich sozusagen mit dem Zufallsprinzip. Und es gibt andere Generatoren, "Chords" oder "BrownChords" zum Beispiel, die mit Intervallstrukturen funktionieren, also das ist eine Harmonik auf einer höheren Ebene, hier werden die Intervallstrukturen zwar auch per Zufall bestimmt, aber es gibt ein ganz strenges Regelsystem, das bestimmte Intervallkombinationen vermeidet und ausschließt. Und dadurch entstehen noch ganz bestimmte Arten von Klängen. Sie kommen als zum Beispiel keine Dur- und Molldreiklänge vor. Es können zwar Terzenschichtungen entstehen, aber alles, was tonal klingt, wird strategisch ausgeklammert.

RV: Man sollte also eine Analyse der Algorithmen machen?

KHE: Wahrscheinlich. Gar nicht jetzt des Outputs, sondern der Komposition des Algorithmus.

RV: Nach Ihrer Meinung, wie wichtig ist es, zu wissen, wie ein Stück funktioniert, um es zu genießen?

KHE: Das ist eine sehr gute Frage. Also in der Postmoderne gibt es den Begriff der Doppelkodierung. Das heißt, ein Kunstwerk ist nicht eindeutig, sondern es spricht mehrere Sprachen gleichzeitig, und man kann auch als Hörer unterschiedliche Sachen hören. Es gibt den Modus des naiven Hörens, wenn man das Stück ohne Information hört, und auf sich wirken lässt, und damit etwas anfängt oder auch nicht. Und es gibt das Spezialistenhören, dass man den Leuten Informationen gibt und sie damit vielleicht schon in eine bestimmte Richtung weist, und sie mit diese Vorinformation einen anderen Fokus setzen lässt. Und dazwischen gibt es viele Möglichkeiten. Ich glaube, es ist beides möglich, und es gibt sicher mehrere Arte von Hören zwischen diesen Spezialistenhören und dem naiven, unschuldigen Hören. Aber ich sage oft, dass die Leute sollen eigentlich möglichst unvoreingenommen an das Stück herangehen.

Performance at the Eslite Performance Hall in Taipei (TW)

with Huikuan Lin (pipa) and Karlheinz Essl (live-electronics)

1 May 2015

Manchmal ist es wichtig einen Kontext zuerst zu erklären. Zum Beispiel, dieses Instrument hier ist eine Pipa. Das ist ein chinesisches Instrument mit einer sehr langen Geschichte. Es ist ein Instrument, das vor allem von Frauen gespielt wird, und es ist ein sehr virtuoses Instrument. Hier ist eine arabische Oud, eine Laute. Interessant ist, dass diese Oud, die als Instrument schon tausende Jahre alt ist, sozusagen irgendwie nach China gekommen ist, und die haben das sozusagen nachgebaut, und diese Version daraus gemacht. Die haben ein anderes Tonsystem, deswegen haben sie jetzt Bünde mit fixen Tonhöhen, und die Oud hat keine Bünde, weil es diese Maqam-Struktur mit Mikrotönen gibt). Und ich habe ein Stück gemacht mit Pipa und Live-Elektronik, und das war nicht einfach ein Stück mit irgendeinem Instrument, sondern ich bin ganz bewusst auf die Geschichte dieses Instruments eingegangen, und habe einen Text gefunden, ein Gedicht von einem sehr berühmten chinesischen Dichter aus dem achten Jahrhundert, was ein Gedicht über die Pipa ist. Das ist voll mit Naturbildern und es beschreibt einen Abend im Spätsommer, wo der Mond aufgeht, und der Fluss fließt, und es gibt Freunde, die miteinander feiern, sich verabschieden, und plötzlich hören sie den Klang einer Pipa, und dann fährt er dorthin, und sieht eine Frau, die Pipa spielt, und ist ganz traurig und verzweifelt, also eine Art Liebesgeschichte. Und ich wollte eigentlich, dass dieses Instrument mit seiner Geschichte irgendwie eine Rolle spielt, und deswegen habe ich das Stück so komponiert, dass dieses Gedicht auch im Stück vorkommt. Ich habe diese Pipa-Spielerin, die chinesisch ist, gebeten, das Gedicht zu zitieren, und habe dann einige Verszeilen genommen, und habe das so gemacht, dass im Laufe des Stücks das Instrument plötzlich beginnt zu sprechen. Ich habe mit Convolution gearbeitet, an bestimmten Stellen kommt dann sozusagen aus diesem elektronischen Klang, den die Pipa auslöst, so etwas wie eine menschliche Stimme heraus. Das ist ein Stück, was eigentlich mit einer bestimmten Art von Tradition arbeitet und auch referenziert, das ist zwischen Asien und Europa, das ist ein Riesenunterschied im Denken. Und ich habe doch versucht, irgendwie eine Verbindung herzustellen. Und wir haben das Stück mehrmals in Taiwan gespielt, und das ist bei den Leuten sehr gut angekommen, weil sie das alles verstanden haben. Also wenn man es in Österreich spielt, hört man zwar, dass die Pipa plötzlich anfängt, zu reden, in einer völlig unverständlichen Sprache, aber für die Chinesen war das toll, weil sie das Gedicht auch kennen. Es gibt in jeder Kultur gewisse Gedichte, die jedes Kind kennt. Also, soviel zur Frage, wie viel Information wichtig ist: manchmal ist es wichtig, manchmal referenziere ich, manchmal möchte ich es auch vermeiden.

KHE: Sehr gute Frage, weil es immer wieder Dinge gibt, die ich an ihm sehr interessant finde; Formalized Musik; habe ich mir großem Interesse gelesen... Ich weiß es nicht! Er ist für mich vielleicht nicht der absolute Referenzpunkt, er kommt auch von einer außermusikalischen Betrachtung. Das ist vielleicht etwas, das ist mir nicht so nah, obwohl ich sehr schätze, was er macht, aber mein Zugang ist eher ein seriell geprägter, und das hat sehr stark abgelehnt, im Grunde haben die beiden sich miteinander gewisser Weise versöhnt oder verbunden, diese Ansätze.

RV: Was ist Ihre Meinung zur Free Software?

KHE: Prinzipiell finde ich, dass das eine ganz großartige Idee ist. Ich meine, ich leide darunter, dass ich wenig mit graphischer Software arbeite, dass die dann unter bestimmten Umstände, wenn ich einen neuen Rechner habe, nicht mehr funktioniert, dann muss ich die neu registrieren und vielleicht auch einen neuen Code kaufen. Das ist extrem mühsam. Ich bin auch gern bereit, für Software zu zahlen. Es gibt zum Beispiel Reaper. Da kann man zahlen oder nicht, und ich habe natürlich gezahlt, weil ich finde, dass es ein gutes Programm ist, und ich weiß einfach, ich kann mich darauf verlassen, die funktioniert einfach, und ich muss mir nicht immer in das System registrieren, um es zum Laufen zu bringen. Also es hat den Vorteil, dass wenn sie gut gemacht sind, sehr verlässlich zu sein. Es gibt auch die Möglichkeit, dass man sie weiterentwickeln kann.

RV: Warum benutzen Sie aber einen Apple Computer?

KHE: Weil ich damit einfach produktiver bin. Also ich bin nicht ein Apple-Befürworter, dass heißt, es musste ein Apple sein. Aber wenn ich mit Studenten, die keinen Apple, sondern einen PC haben, ist es einfach extrem mühsam, die gleichen Sachen zu machen, außer wenn die Leute extrem gut sind, und können einfach auf einer tieferen Ebene mit dem Betriebssystem gut arbeiten. Aber ein durchschnittlicher Computerbenutzer, also ein Windows-Rechner im Multimediabereich, ist auf jeden Fall einen Apple-User unterlegen. Und das hängt auch mit dem Betriebssystem zusammen, mit dem ganzen "graphical user interface", und mit der Philosophie dahinter. Es ist bei Apple einfach besser gelöst. Das Problem ist, dass Apple jetzt immer mehr zu einem Consumerprodukt wird, und vieles, was früher war, an Einstellung vorzunehmen, nicht mehr so einfach geht. Ich kann mich erinnern, dass ich früher meine alten Apples so konfiguriert habe, wie ich es brauchte, ich habe sehr viel mit dem Betriebssystem gemacht, und sie so hergerichtet, dass sie ganz auf mich zugeschnitten sind, und das ist heute sehr mühsam, und funktioniert heute auch nicht gut, und deswegen macht man das nicht, und nun muss ich wirklich mehr arrangieren, und dann, weil plötzlich Dinge eingebaut sind, wie jetzt diese Upgrades zwischen iPhone und Apple und iPad, das heißt die Cloud, und alles wird miteinander immer benutzerfreundlicher, und manchmal auch für den Poweruser ein bisschen mühsam. Das ist also der Grund, warum ich jetzt nicht mit dem neuesten Betriebssystem arbeite. Ich bin noch mit macOS 10.9, weil das auch bei meinen Kollegen im Multimediabereich einfach stabiler ist. Also ich habe mittlerweile einen vier Jahren alt Computer, ich habe erst die Harddisk ersetzt durch eine SSD, und seitdem ist der Rechner um ein Vielfaches schneller, und es funktioniert alles! Also, wenn jemand mir mal sagt, einen neuen Computer für 2000 Euro zu kaufen, frage ich: wozu? Das brauche ich nicht, es läuft alles perfekt, und ich bin damit absolut zufrieden. Es geht also um die Produktivität, ich habe die Erfahrung, dass man mit dem Betriebssystem von Apple besser zurechtkommen kann als mit anderen Betriebssystemen.

RV: Und gestern war Apples Apfel auf Ihren Laptop von einem "E(ART)H" Aufkleber versteckt.

KHE: Ja, ich habe es aufgeklebt. Ich denke: wenn ich Werbung mache für die Apple-Firma, dann muss sie mir etwas zahlen, zumindest einen Computer. Und wenn sie das nicht macht, okay, dann mache ich keine Werbung. Außerdem stört das auch, wenn man spielt, dass immer dieser Apfel leuchtet. Diese Werbung möchte ich nicht. Und was ich benutze, war mal so ein Aufkleber in einem Kunstprojekt, den ich einfach schön fand, und auch stimmig.

RV: Wie verdienen Sie Ihren Lebensunterhalt?

KHE: Ich habe eine Professur an der Wiener Musikuniversität. Das ist mein Haupteinkommen. Dann habe ich meine freie Tätigkeit als Komponist und Musiker. Und ich habe bis jetzt noch einen Tätigkeit hier im Museum als Kurator für Musikveranstaltungen und Konzerte. Und früher war ich auch der Webmaster vom Museum. Dieser Job hört leider auf: ich hatte drei Jobs, und jetzt habe ich nur noch zwei.

RV: Und machen Sie oft kostenlose Konzerte wie gestern?

KHE: Die Konzerte hier im Museum sind immer kostenlos. Und wenn ich woanders spiele, ist es verschieden. Also ich bin nicht der Veranstalter, es hängt von dem Veranstalter ab. Es kann sein, dass das ein ganz normales Venue ist, wo die Leute fünfzehn Euro zahlen müssen, oder es kann auch gratis sein, wenn es in einem anderen Kontext stattfindet.

RV: Wie ist Ihre Meinung zum Problem der illegalen Downloads?

KHE: Meine persönliche Haltung ist, dass ich für Sachen zahle, sei es, wenn ein Musikstück mir gefällt, und ich möchte es gerne haben, oder wenn ich im Unterricht eine gewisse Aufnahme brauche, dann kaufe ich das, weil ich denke, dass das einfach wichtig für die Autoren ist, dass die das auch abgegolten bekommen. Da Sie meine Webseite kennen, wissen Sie, dass ich viele Sachen herschenke. Also wenn jemand Partituren von mir will, dann muss er sie nicht kaufen, sondern sie können frei heruntergeladen werden. Auch die Software ist bis auf wenige Ausnahmen, es gibt zwei Shareware-Softwaren, da muss man Registrierungscode zahlen, ist frei. Und das mache ich ganz bewusst, weil dadurch die Schwelle, ein Stück zu verbreiten, einfach gesenkt wird. Ich weiß als Veranstalter, wie schwierig das oft ist. Wenn man von Fausto Romitelli, einem italienischen Komponisten, eine Partitur möchte, dann muss man ihm ein Brief an Ricordi schreiben, und dann muss man zwei Monate warten bis zur Antwort, dann dauert es ein halbes Jahr, bis die das Material schicken, und dann kriegt man es vielleicht doch nicht. Ich hatte selber einen Verlag in Deutschland, der war genauso. Wenn Leute eine Ansichtspartitur haben wollten von einem Stück von mir, dann hat der Verlag die Sache am Anfang noch verschickt, und die Leute haben dann aufgrund dessen gesagt: okay, das Stück machen wir, das passt, und haben das Material, die Stimmen gekauft. Der Verlag hat es mittlerweile so gemacht, mein alter Verlag, dass jeder, der eine Partitur von mir sehen wollte, dafür zahlen musste, und meine Aufführungen von diesem Werk sind drastisch heruntergegangen. Und ich habe mich frei gekauft, dass heißt ich habe das Verlagsverhältnis beendet, habe eine bestimmte Summe zahlen müssen, und habe jetzt alles Material bekommen von denen, das waren fünfzig Kilo Papier. Und jetzt bin ich frei, ich habe meine Sachen, jetzt habe ich alles eingescannt. Und wenn Leute meine Sachen spielen, dann können sie sie wieder gratis herunterladen. Das ist eine Entscheidung von mir. Ich bin darauf gekommen, dass sich meine Musik dadurch besser verbreitet, und ich verdiene das Geld nicht durch Papier, sondern durch die Aufführungstantiemen. Also, wenn es ein richtiges offizielles Konzert ist, wird über SACEM oder GEMA oder AKM die Gebühren eingehoben, und die bekomme ich dann. Und wenn ich eine Partitur zum Beispiel fünfzehn Euro verrechne, die dann irgendwie ausgedruckt wird, dann in den Copyshop laufen muss, die dann irgendwie zu binden, und einen Umschlag zu geben, eine Rechnung zu schreiben, und dann das bei der Steuer anzumelden und fünfzig Prozent kriegt dann der österreichischen Staat. Also, das rechnet sich nicht. Der Aufwand ist in keinster Weise so, dass man davon leben kann. Deshalb sage ich: alles gratis, aber die Sachen sind registriert, sind bei der SACEM angemeldet, und ich bekomme Tantiemen dafür.

RV: Was ist Ihre Meinung zum Schutz des Privatlebens im Internet?

KHE: Ich sehe einfach, dass wenn man die Vorzüge von Google und Facebook nutzt, dass man damit auch seine Seele verkauft. Und damit muss man sagen, entweder: das akzeptiere ich, oder: ich mache es nicht. Für mich überwiegen die Vorzüge. Es ist so, dass ich sehr viel veröffentliche. Mein Facebook ist nicht ein privates Facebook, wo ich über Familiensachen oder private Dinge schreibe, sondern nur künstlerische Sachen, die mit meiner künstlerischen Arbeit zu tun haben. Und da bin ich eigentlich froh, wenn sich das verbreitet. Aber ich weiß auch natürlich, dass jede Suchanfrage, die ich mache, von Google registriert wird. Die einzige Möglichkeit ist, sich dem zu verweigern. Und ich kenne auch Leute, die sagen, sie wollen keinen Computer, kein Handy... Sollen sie machen, aber die Vorzüge sind so groß, und ich brauche sie auch so, dass ich sozusagen meine Seele verkauft habe. Für mich macht das derzeit keine wirklichen Probleme. Ich bin aber schon vorsichtig, im Bezug auf Postings zum Beispiel. Ich überlege mir ganz genau, was ich schreibe, und wie ich es formuliere, und mache nicht irgendeinen Blödsinn. Mir ist schon klar, dass ich alles, das ich im Internet mache, irgendwie Teil der Internetblase wird, und irgendwo, auch wenn es jetzt nicht aktuell jemand sieht, aber das kann ganz leicht wieder herausgefunden werden. Es gibt Dinge, also Beispiele von einem deutschen Musiker, der in Amerika eingereist ist, und den sie dann festgenommen haben, und sie wussten innerhalb von fünf Minuten alles über ihn, indem sie seine ganzen sozialen Netzwerke durchforstet haben mit speziellen Algorithmen, und sofort gewusst haben, mit wem er Kontakte hat, und wie viel er mit wem telefoniert, und so weiter. Das ist eine Tatsache, die ich einfach nicht zurückverändern kann. Ich bin mit Clouddiensten sehr vorsichtig, ich verwende sie auch, aber viele Sachen auch nicht.

RV: Interessieren Sie sich für die Fortschritte der künstlichen Intelligenz?

KHE: Im Künstlerischen überhaupt nicht. Ich finde es interessant, ich lese auch Fachzeitschriften, wo darüber geschrieben wird, aber im Musikalischen interessiert mich das nicht. Also "Artificial Intelligence" habe ich im künstlerischen Bereich nie interessant gefunden. Weil, dann frage ich mich, was meine Rolle als Künstler ist... Zum Beispiel die Lexikon-Sonate hat nichts mit AI zu tun, sie ist absolut dumm! Aber sie macht deswegen etwas Schönes, weil ich als Erfinder des Programms Ideen von mir realisieren konnte, auch wenn der Computer sozusagen das macht, was ich ihm vorgeschlagen habe, aber auch nicht vor sich auf Dinge erfindet.

KHE: Interessieren Sie sich für Videospiele, und besonders für die Videospielmusik, die eine andere Art von algorithmischen Musik ist?

RV: Es ist eigentlich interessant, aber ich habe damit noch nichts gemacht. Also, keine Ahnung. Mich haben schon Leute kontaktiert, die haben gesagt: ja, es würde unglaublich passen, also die Werkzeuge, die ich habe, ließen sich gut verwenden. Aber es hat sie noch keine konkrete Auftragssituation ergeben. Aber generell würde es mich interessieren. Ich bin zwar kein Videospieler, aber ich sehe einfach, wie toll diese künstlichen Welten jetzt geworden sind, also das ist absolut faszinierend. Und auch diese Interaktion, dass man sozusagen nicht einen Film schaut, sondern den Film selber mitgestaltet. Aber ich habe überhaupt keine Ambition für Videospiele. Mein erster Computer war dieser Atari, und es gab zwei Sachen darauf: Basic und auch ein "Textadventure". Und dieses Textadventure habe ich dann gespielt, und ich bin total süchtig geworden, und habe es dann gelöscht, und gesagt: ich werde nie mehr so was machen, weil die Gefahr sehr groß ist, dass man sich darin verliert, und stattdessen habe ich begonnen, Computeralgorithmen für Musik zu erfinden!

RV: Ist die Qualität der Lautsprecher wichtig für Sie, wenn Sie Konzerte machen?

KHE: Extrem wichtig, weil ich ein großer Kritiker von normalen Lautsprechern bin. Ich finde das ein ganz scheußliches Instrument. Deswegen haben wir gestern auch diese Bose[-Lautsprecher] verwendet, diese L1. Und ich glaube, dass es genau das Richtige war, für diese Art Musik, weil sie den Klang sehr breit fächern, weil sie nicht als schwarze Würfel irgendwie den Klang wie so Klangkeil ausstrahlen, sondern sie bilden eine Fläche. Und lösen gut auf. Ich habe es eine ganz interessante Sache gefunden, wenn ich im kleinen Kontext spiele, also in kleinen Räumen, wo ich nicht dazu mit den großen Lautsprechern mitschleppen möchte, und es gibt dort ein Klavier, ein Grand Piano, dann verwende ich den Resonanzboden des Klaviers als Lautsprecher. Ich habe einen Spezial-Lautsprecher, den kann man noch den Resonanzboden stellen, das ist ein Transducer. Und die Schwingung überträgt sich dann auf den Resonanzboden, und erzeugt damit eine Lautsprechermembran. Das kommt dann aber aus dem Klavier. Wenn man den Deckel des Klaviers aufmacht, hat man so zu sagen eine akustische Linse, und das klingt unglaublich toll.

RV: Das haben Sie auch schon mit der Lexikon-Sonate gemacht!

KHE: Genau. Das ist toll, weil das wirklich wie Klavier klingt, und kommt aus dem Klavier, aber ich spiele nicht auf den Tasten, und das ist auch kein Diskklavier. Und ich habe in den letzten Jahren öfters gemacht, mit elektronischen Stücke, ohne Klavier-Kontext, und das funktioniert gut.

Karlheinz Essl performing Lexikon-Sonate on a Steinway, equipped with a transducer

The Hague (Royal Conservatory of Music), 29 Nov 2014

RV: Gibt es ein Einfluss von Rock auf Ihre heutige Musik?

KHE: Vielleicht nur, in manchen elektronischen Stücken, also diese Idee des "Sounds". Also es ist nicht der Rhythmus, oder der "Groove", sondern eher diese sehr starke Orientierung am "Sound". Das kommt vielleicht irgendwie aus der Rockmusik. Das hat sich dann aber auch erst dann wiederum in meiner Musik hineingeschlichen, als ich begonnen habe, mit Elektronik zu arbeiten, und ich habe auch viele Stücke für E-Gitarre geschrieben, auch Ensemblestücke mit E-Gitarre, und da war es sehr wichtig, diese spezielle Art von ... "Sound" zu verwenden allerdings jetzt ohne in irgendwelche Rockklischees zu verfallen.

RV: Gibt es technologische Erfindungen, die für Ihre Karriere wichtig gewesen sind?

KHE: Ich habe immer als Künstler versucht, eine Autonomie zu haben. Ich wollte nicht abhängig sein von irgendwelchen Institutionen. Und mir war es immer wichtig, dass ich alles zu Hause machen kann. Sie sehen, mein Studio besteht im Grunde aus einem Laptop. Ich brauche zum Beispiel keinen "Synthesizer". Es ist ein Zufall, dass ich da einen habe. Das ist ein uraltes Instrument, das ich vor langer Zeit einmal gekauft habe, aber ich verwende es eigentlich nicht. Also, die Technologie, die digitale Technologie hat es mir ermöglicht, ein autonomes Künstlerdasein zu machen, unabhängig von Institutionen. Diese Autonomie war auch der Grund, warum ich es immer abgelehnt habe, mit Standardsoftware zu arbeiten, also mit ProTools Logic und so weiter. Weil diese Ideen, die dahinter stehen, sind eigentlich sehr konservativ. Also, wie früher, wenn man mit Tonbandmaschinen gearbeitet hat, es ist jetzt anders organisiert, aber im Grund ist es immer die gleiche Idee: mit "Timeline" und so weiter, aber mich hat eigentlich immer ein Ansatz interessiert, der wirkliche nur mit Computer geht.

RV: Gibt es auch Erfindungen, die Sie vorsehen oder erwarten?

KHE: Nein. Also, mich interessiert auch nicht diese ganze Spekulation mit "Artificial Intelligence" und, ich weiß nicht... Ich sehe vieles, was passiert, und mag es jetzt nicht so, dass ich da jetzt auf jeden Zug aufspringe und alles benutzen muss. Ich habe lange viel experimentiert, mich interessiert natürlich, wie ich Algorithmen kontrollieren kann. Es gibt eine naive Vorstellung von Leuten, die meistens nicht unbedingt Musiker sind, man könnte den Klang skulptural Formen (große Bewegungen), so wie eine Skulptur aus Ton formen. Aber die Wirklichkeit ist, dass Klang ein ganz anderes Phänomen ist. Der Klang ist ein Phänomen, das nicht vergleichbar ist mit einem Stück Ton. Das ist auch nicht dreidimensional, es ist einfach viel komplexer. Und das kann man nicht einfach so, dreidimensional, in der Luft mit Händen formen und dann entsteht etwas. Ich glaube das nicht, und alles, was ich bis jetzt gesehen habe, ist einfach trivial und lächerlich. Für mich ist der Klang eine ganze komplizierte Interaktion von viele verschiedenen Parametern und Schichten, und Algorithmen, die sich gegenseitig durchdringen, und dann zuletzt den Sound als oberste Kategorie formen. Und da sind wir wieder bei der Rockmusik, weil der Sound auch ein Konzept ist, das eine Rolle bei der Rockmusik spielt.

RV: Was ist Ihre Beziehung zum Essl Museum?

KHE: Das ist ein Museum, das meine Eltern gebaut haben. Meine Eltern sammeln schon seit vielen Jahrzehnten Kunst und haben sich dann entschieden, vor zwanzig Jahren, ihre Sammlung öffentlich zu machen. Sie haben dann ein Museum gebaut, das siebzehn Jahre lang im Betrieb war, und das Problem ist, dass die Firma meines Vaters finanzielle Schwierigkeiten hatte aufgrund der Finanzkrise, sie musste verkauft werden, und die Mittel für den Betrieb des Museums waren nur private Mittel, die sind nicht mehr vorhanden, und weil wir keine Unterstützung bekommen haben von öffentlicher Hand, hat mein Vater schweren Herzens nach vielen Kämpfen und Verhandlungen entscheiden müssen, den Museumsbetrieb zu schließen, einzustellen. Das Haus wird weiter als Depot genutzt, weil es im Erdgeschoss ist, die ganze Räume im Erdgeschoss sind Depoträume, wo die Bilder professionell gelagert werden. Das war eine sehr schwere Entscheidung. Und die Konzerte, die ich hier gemacht habe, das war auch eine Schiene von experimentellen Musikkonzerten, die nicht woanders gut hineinpassen. Also, nicht in ein Konzerthaus oder eine Philharmonie, sondern zu Kleinerem, ich habe sehr viel mit Leuten gearbeitet, die also experimentell unterwegs sind, und Sachen ausprobieren, und hatte eine "Community" gebaut, die dann auch kommt und sich das anhört.

RV: Und was ist die Beziehung zwischen Ihrem künstlerischen Projekt und den künstlerischen Projekten des Museums?

KHE: Als das Museum gebaut worden ist, hat sein Architekt Heinz Tesar von Anfang an gesagt, dass die Musik dort eine Rolle spielen soll, und hat deswegen auch dieses Studio gebaut. Also, das ist eigentlich ein Raum, das ist ein Würfel: das ist sechs mal sechs mal sechs Meter. Und er hat gesagt: das ist die Grundstruktur des Hauses, es muss irgendwo einen Raum geben, der diese sechs mal sechs mal sechs Kantenlänge hat. Das ist ein Raum, den man nicht für ein Büro benutzen kann. Und dann hat er gesagt: da muss der Komponist hin. Und das er hat von Anfang an so gebaut, dass in den verschiedenen Räumen des Hauses Lautsprecherkabel verlegt worden sind. Ich habe am Anfang, in den ersten zehn Jahren, sehr viele Klanginstallationen hier gemacht, mit verschiedenen Künstlern. Die Idee war, Ausstellungen zu bilden, die ganz spezielle Klangenvironments schafft, und ich habe sehr viel damit experimentiert. Und ich bin darauf angekommen, dass dieser generative Ansatz sehr wichtig ist, wenn Besucher nämlich einen ständigen Loop hören, oder Leute, die im Museum arbeiten, wie Aufseher, und sie hören über drei Monate lang alle zwei Minuten den gleichen Loop, dann werden sie am Ende ins Irrenhaus eingeliefert. Und deswegen war es ganz klar, dass die Musik, die man dort verwendet, sich ständig verändern muss und immer interessant sein muss. Und das hat mich eigentlich auch sehr stark in meiner eigenen künstlerischen Arbeit in Berührung gebracht, und ich habe auch sehr viel gelernt, aus der Erfahrung auch mit dem Publikum, wie es darauf reagiert.

| Home | Works | Sounds | Bibliography | Concerts |

Updated: 1 Feb 2022